色情直播

色情直播

一共三款模子,初度秉承MoE架构,开启了原生多模态的Llama期间!

Llama 4 Scout,激活17B,16个各人,109B参数;

Llama 4 Maverick,激活17B,128个各人,402B参数;

Llama 4 Behemoth,激活288B,16个各人,2T参数。

Llama 4发布后排行骤然跃升,甚而擢升了DeepSeek-V3,Meta再一次回到牌桌。

业界首个1000万高下文,RAG已死?

Meta声称Llama-4-Scout-17B-16E测试中好于Gemma 3、Gemini 2.0 Flash-Lite和Mistral 3.1。甚而,小扎剧透了推理模子也不远了。

但也有网友辱弄Llama 4此次是“打鸭子上架”,是以Llama 4性能到底如何,请看底下网友的实测。

疏淡MoE模子,和苹果芯号称乱点鸳鸯

现时,第一批测试截止还是出来了!

苹果ML工程师Awni Hannun实测,Llama 4 Maverick在单台M3 Ultra-512GB上使用MLX推理框架时速率极快,达到了50 token/秒!

与DeepSeek V3/R1近似,Llama 4系齐是巨大的疏淡MoE模子。

这些模子领有极其遍及的参数目,但每次只没趣少参数(各人)被激活。由于预先无法展望哪些参数会被激活,因此必须把整个参数同期存放在高速的GPU显存中。

为何关于开源模子,社区大佬齐倾向于使用苹果芯片去测试?

一方面,是因为买不到英伟达H100啊。

Awni Hannun暗示,更蹙迫的是Apple芯片符合疏淡模子。

GPU显存速率快,但资本不菲。关系词Apple Silicon通过斡旋内存(Unified Memory)和UltraFusion 时间和会多个芯片,使其能够以更低的资本提供更大容量、中等速率的内存。

一个月前发布的M3 Ultra Mac Studio的斡旋内存容量高达512GB!

关系词,当内存容量增大到这个进程时,内存带宽就不及了。关于512GB版蓝本说,内存刷新率(每秒GPU可完好遍历整个内存的次数,即内存带宽与容量之比)只消1.56次/秒。与其他硬件对比如下:

NVIDIA H100(80GB):37.5次/秒

AMD MI300X(192GB):27.6次/秒

Apple M2 Ultra(192GB):4.16次/秒(比H100慢9倍)

Apple M3 Ultra(512GB):1.56次/秒(比H100慢24倍)

理念念情况下,工作负载特色应与硬件特色相匹配。不然,硬件会存在花消(性能多余)或瓶颈(性能不及)。对工作负载(此处为批大小=1的推理任务)而言,要道特色是模子疏淡度。

模子的疏淡度界说为 1-(激活参数数/总参数数)。

繁多模子疏淡度为0%(因为激活参数 = 总参数)。各模子疏淡度如下:

Llama 3.3 405B:总参数=405B,激活参数=405B,疏淡度=0%

DeepSeek V3/R1:总参数=671B,激活参数=37B,疏淡度=94.4%

Llama 4 Scout:总参数=109B,激活参数=17B,疏淡度=84.4%

Llama 4 Maverick:总参数=400B,激活参数=17B,疏淡度=95.75%(相配高!)

Llama 4 Behemoth:总参数=2T,激活参数=288B,疏淡度=85.6%

一般来说,疏淡度越高,越符合内存刷新率较低的Apple Silicon。因此,Llama 4 Maverick赫然是最符合 Apple Silicon的模子。

另外更蹙迫的原因等于Apple Silicon是开动大模子最具资本效益的决策,因为斡旋内存每GB的资本远低于GPU显存:

NVIDIA H100:80GB,3TB/s,售价$25,000,每GB资本$312.50

AMD MI300X:192GB,5.3TB/s,售价$20,000,每GB资本$104.17

Apple M3 Ultra:512GB,800GB/s,售价$9,500,每GB资本$18.55

以2万亿参数巨兽Llama 4 Behemoth为例。

商量到若用H100来完好容纳Behemoth模子(fp16精度),则需要50块H100,总资本为125万好意思元;

MI300X的总资本则为42万好意思元;

但若使用M3 Ultra,总资本仅为7.6万好意思元!

以下是网友@alexocheema对不同版块Mac开动新Llama 4版块的情况进行了全面分析。

Llama 4此次发布的模子最大一个优点之一等于疏淡模子,这给了腹地部署好多念念象力,亦然开源模子的工作。

以精度4-bit为例,使用MLX推理框架不错在具有充足RAM的Mac上部署这些模子。

网友@awnihannun纪念了部署Llama 4最新三个模子所需要的最小树立,委果齐不错完资腹地部署:

Llama 4 Scout 109B参数:64GB的M4 Max;

Llama 4 Maverick 400B参数:256GB的M3 Ultra;

Llama 4 Behemoth 2T参数:3台512GB的M3 Ultra;

Llama 4很强,等于写代码有点菜

说完结硬件,再来望望Llama 4的实测遵守。

网友@gnukeith测试了Llama 4的多模态才能,让模子识别图片中的东谈主物来自于哪个动漫,Llama生效识别!

网友@attentionmech制作了一个模子视觉化网页(简便说等于看模子有几许层,有多深),Llama 4视觉上看起来如实令东谈主咋舌。

网友@philip_kiely使用Llama 4(Maverick)应酬打败了Brick Breaker氛围测试。

诚然,也有翻车的,比如网友@fighto测试了“雅俗共赏”的让模子数r的问题,Llama 4 Maverick回话作假。

网友@tariquesha1测试了Llama 4的图像生成才能。

再来望望Llama 4写代码的实战案例。

网友AlexBefest文书Llama 4 Maverick——Python六边形测试失败。Python六边形测试不错说是每个新发布大模子的“试金石”了。

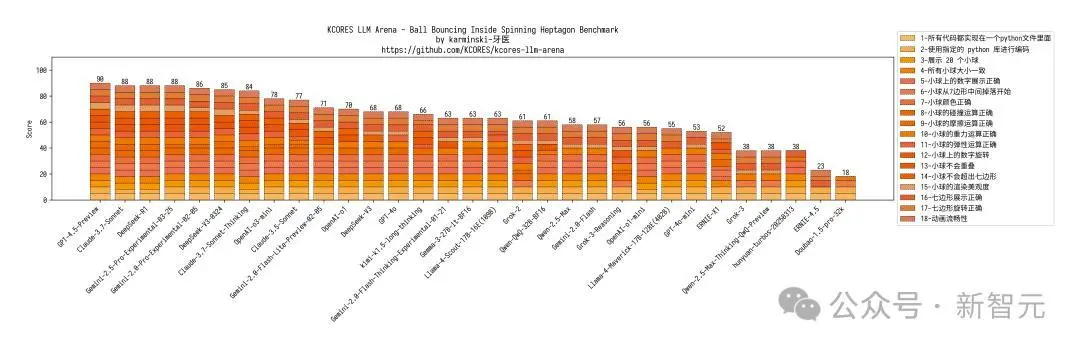

底下展示了其他模子在Python六边形测试弹跳小球上的截止,来自Github的KCORES团队。

KCORES团队成员karminski-牙医发布了Llama 4 Scout和Llama 4 Maverick的测试截止。

用他的话说,Llama 4 Scout小参数模子爽快就好;足足有402B参数的Maverick模子的发扬并不是很恬逸:

Scout小参数模子约略接近Grok2的水平(咋还倒退了);

而Mavericks还不如使用DeepSeek-V3-0324;

总之不淡薄Llama 4写代码

按照KCORES LLM Arena的评测截止,当今最佳的模子GPT-4.5-Preview。

诚然,当今的测试只针对写代码,其他长文本和多模态限度还需要更多的测试案例。

Llama 4的另一个冲破等于复旧10M的高下文窗口长度,特别于20个小时的视频。

全网部署Llama 4

非论怎样说Llama 4的发布依然是开源模子的又一剂强心针。

各家巨头和平台同期文书复旧最新的Llama 4。

微软CEO Satya Nadella文书立地将Scout和Maverick发布在Azure AI Foundry平台。

Cerebras文书将不才周完成Llama 4最新模子的部署。

Together AI上也同步推出Llama 4模子,动作Meta的发布谐和伙伴,还复旧Together API的模样来探听Llama 4 Maverick 和Llama 4 Scout。

T3 Chat也文书Llama 4 Scout和Maverick均已启动,Scout由Groq托管,而Maverick由OpenRouter托管,何况声明了小参数模子Scout相配低廉,决定免费发布。

Databricks数据智能平台文书使用Llama模子来为AI期骗范例、智能体和工作过程提供复旧。

接下来还会有更多的平台跟进Llama 4最新模子,就像几个月前各家平台亦然“任意”上线DeepSeek相似。

还有一个问题,为啥小扎选在他们的休息日发布Llama 4,立地就周一了啊?

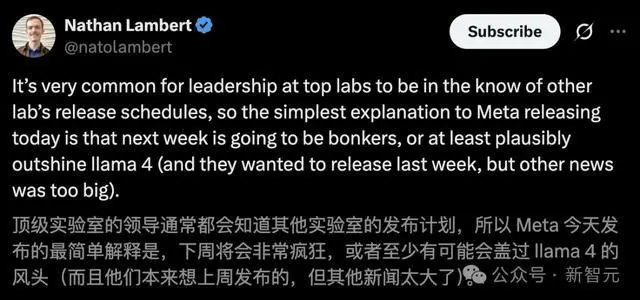

Defined和Liftoff的勾搭首创东谈主Nathan Lambert说顶尖Lab的指引们齐会知谈其他Labs的发布计较。

难谈说小扎知谈下周会有什么“任意”的模子发布可能会盖过Llama 4的风头,是以“打鸭子上架”吗。

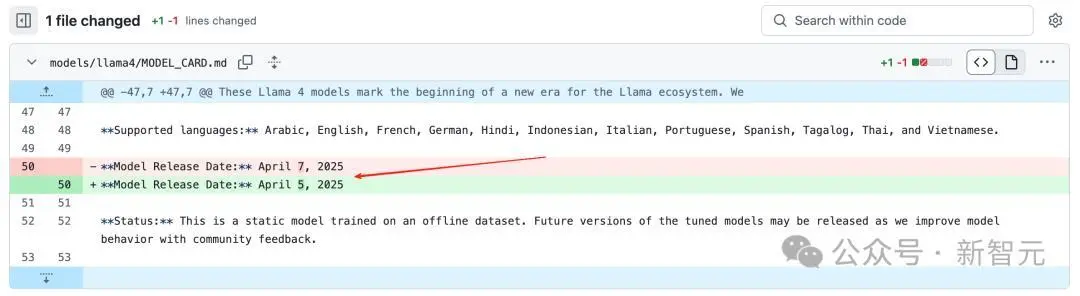

领先在Llama 4的Github Model_Card的更新日记中,发现一个转变:

模子发布的日历从好意思国时候的4月7号改到了4月5号(也等于咱们4月6号的凌晨)!

是以,周一Meta还会发布什么新模子吗?

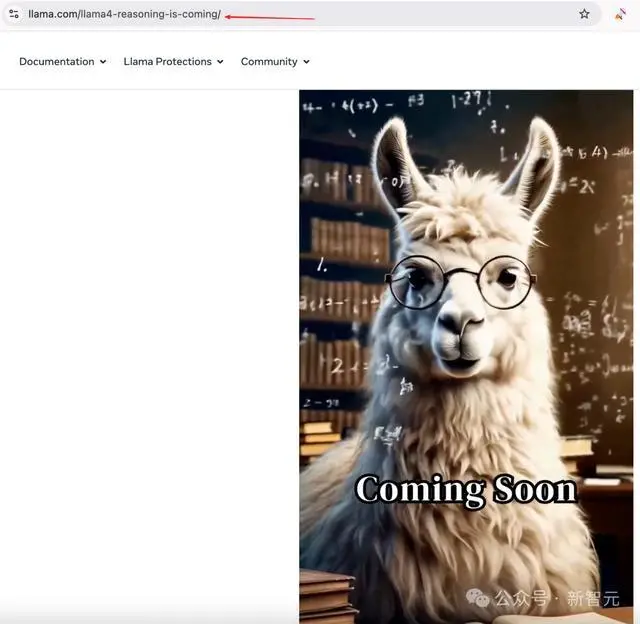

在llama.com的官网上,咱们看到了llama4-resoning-is-coming的后缀,似乎预示着llama-4推理模子也要立地发布了!

而奥特曼不时放出他的烟雾弹,在酬酢媒体抑制的预热:OpenAI接下来也要放大招了!

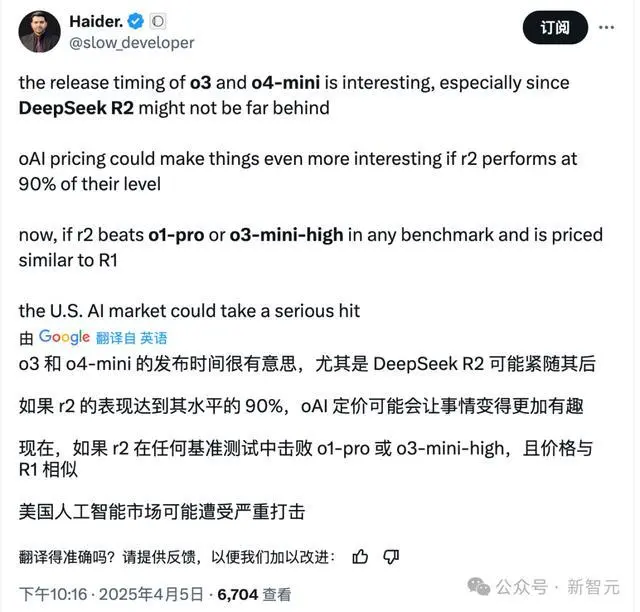

而无论是此前奥特曼文书GPT5、o3和o4-mini的音书,如故Llama 4的发布,如故DeepSeek和清华共同发布的论文,似乎预示着一件事:

整个东谈主齐在恭候并期待着DeepSeek-R2!

请环球作念好准备色情直播,也许下周行将是“任意”的一周。